DeepSeek R1是一个免费的开源语言模型,这个强大的大型语言模型 (LLM) 与 GPT 等顶级人工智能模型正面交锋,在推理、编码和解决问题方面表现出色,而且所有这些都可以在您自己的机器上运行。不再依赖昂贵的基于云的工具。。将它与vscode 插件例如cline/roo code 或者Continue.dev 结合使用,可以将这个 AI 变成一个成熟的编码代理,你就拥有了一个强大的设置,可以自动编写、调试甚至执行代码.最重要的是,所有这些都无需花一分钱!

一、为什么 DeepSeek R1 最近受到如此热议?

1. 完全免费开源

它是免费且开源的:与许多收费昂贵的模型不同,您可以免费使用它。它也可以在deepseek官网上进行聊天。与专有模型不同,DeepSeek R1 完全开源且可用于商业用途。没有代币限制,没有隐藏费用——只有原始的 AI 能力。

2. 性能媲美付费机型

DeepSeek R1 在编码、数学和逻辑推理方面表现出色。例如,其 32B 参数变体在代码生成基准测试中优于 OpenAI 的 o1-mini,其 70B 模型在复杂任务中与 Claude 3.5 Sonnet 相匹配。

3.灵活的部署选项

您可以在本地运行以确保隐私和速度,也可以使用 DeepSeek 的经济实惠的 API(每百万个代币低至 0.01 美元)进行基于云的访问。 要在本地运行(LLM),有从 1.5B 到 70B 参数的模型,因此您可以根据您的硬件选择最适合您 PC 的模型。

4.易于集成

您可以使用Cline、Roo Code、continue.dev、aider等扩展将其连接到 VSCode 。本地运行是免费的,但如果您想使用 DeepSeek API,则需要支付费用。好消息是价格比竞争对手低得多。

二、开始前的重要提示

硬件资源:如果您的电脑性能不是很强大,请优先使用较小的模型(1.5B 或 7B 参数)或量化版本。

使用显卡:建议使用显卡,因为仅依靠 CPU 运行速度较慢。如果你的本地的显卡性能很低,推荐使用deepseek的api,价格很便宜,不必再折腾了。或者使用这个groq平台部署的免费DeepSeek-R1-Distill-Llama-70b模型。

隐私:在本地运行意味着您的数据保留在您的电脑上,不会进入外部服务器。

三、如何在本地运行 DeepSeek R1

方案一. 使用 LM Studio

下载并安装 LM Studio:只需访问LM Studio网站并下载适合您系统的版本。

-

安装配置

- 从LM Studio官网下载安装包

- 在"发现"标签页搜索"DeepSeek R1"

- MacBook用户选择MLX版本

- Windows/Linux用户选择GGUF版本

-

启动服务

- 加载已下载的模型

- 在开发者选项启用服务器(http://localhost:1234)

继续执行步骤 四 与 VSCode 集成!

方案二、使用Ollama

安装 Ollama :从Ollama网站下载Ollama本身并安装。

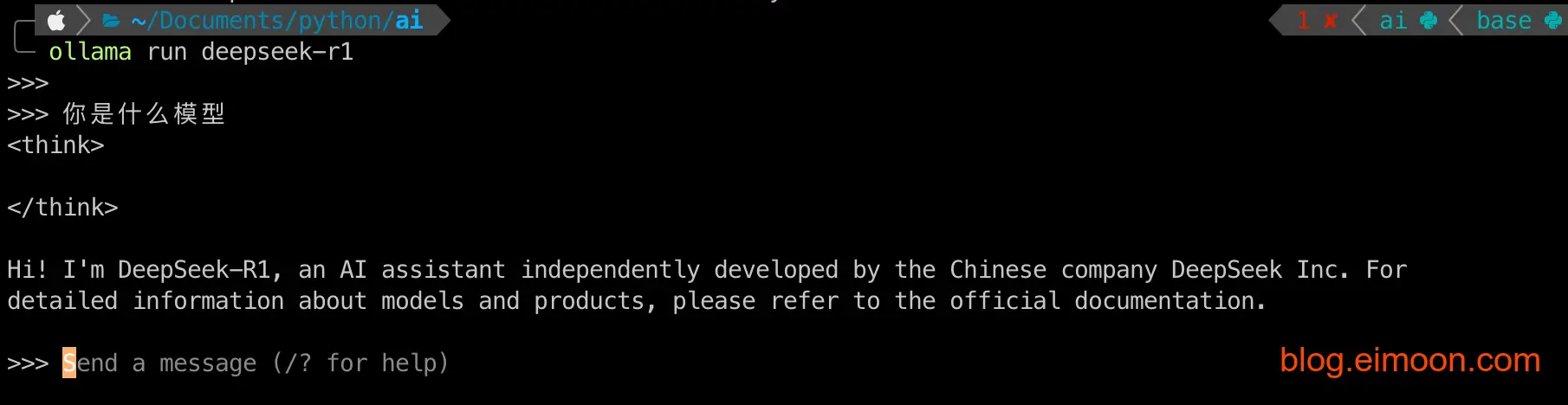

然后下载模型:在终端中运行:

ollama pull deepseek-r1

这是主要模型;如果您想要较小的模型,请转到https://ollama.com/library/deepseek-r1并查看在终端中运行哪个命令。

启动服务器:在终端中执行:

ollama serve

该命令将开始运行模型,他的默认地址是http://localhost:11434。

到这里就可以在本地使用deepseek了,如果你想图形化的界面,可以安装浏览器插件 Page Assist 或者在 ollama github 文档上选择ui界面下载 ollama-webui 进行图形化操作。

下一步我们继续把ollama 与 VSCode 集成!

方案三 使用 Jan.ai

下载并安装 Jan :在Jan网站上选择适合您系统的版本。

下载模型:在 Jan 中无法直接找到 DeepSeek R1。因此,需要前往Hugging Face网站并手动搜索“unsloth gguf deepseek r1”。找到了所需的版本,单击“使用此模型”按钮,并选择 Jan 作为选项。模型在 Jan 中自动打开,然后下载它。

加载模型:下载后,选择模型,点击加载。

启动服务器:Jan 自动启动服务器,通常地址是 http://localhost:1337。

继续执行步骤四 与 VSCode 集成!

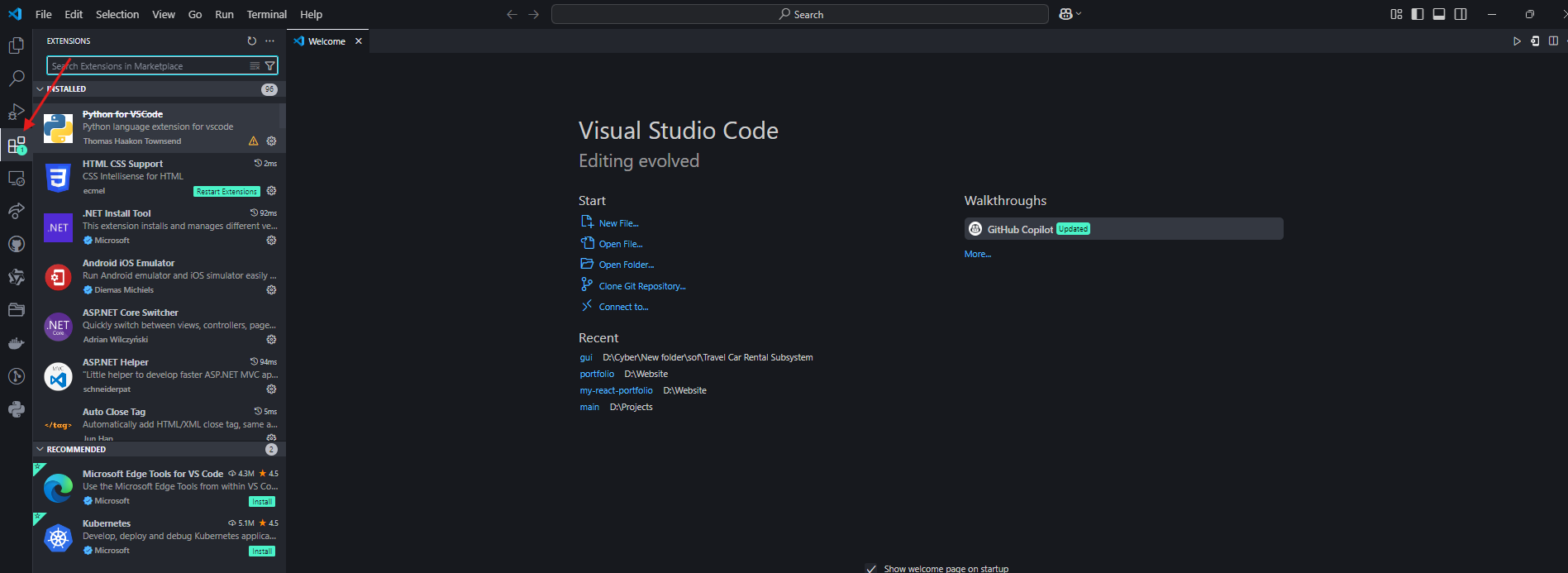

四 与vscode 相关插件集成

方案1.使用Roo Code/cline插件

为 LM Studio 配置Code/cline扩展:

- 点击扩展并访问“设置”。

- 在API 提供程序中,选择“LM Studio”。

- 在基本 URL字段中,输入在 Jan 或 LM Studio 中配置的 URL。

- 如果您只有一个可用模型,则模型 ID字段将自动填充。否则,请手动选择您下载的DeepSeek模型。

- 单击“完成”即可结束。

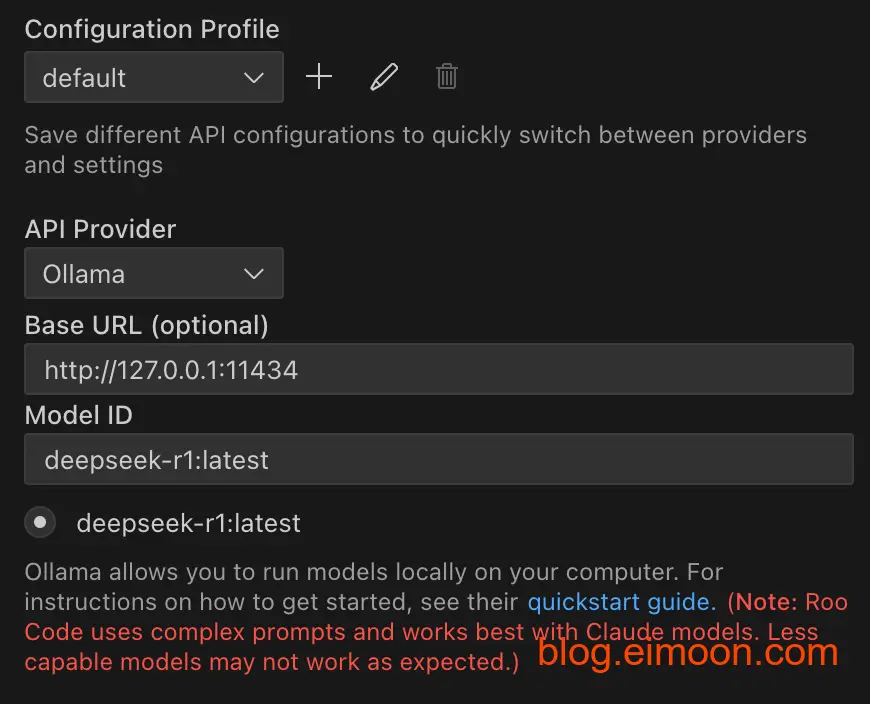

配置 Ollama 的Code/cline扩展:

- 点击扩展并访问“设置”。

- 在API 提供程序中,选择“Ollama”。

- 在Base URL字段中,输入在 Ollama 中配置的 URL(可选):http://127.0.0.1:11434。

- 如果您只有一个可用模型,则模型 ID字段将自动填充。否则,请手动选择您下载的DeepSeek模型。

- 单击“完成”即可结束。 集成完成,现在只需享受 Cline 或 Roo Code 的功能

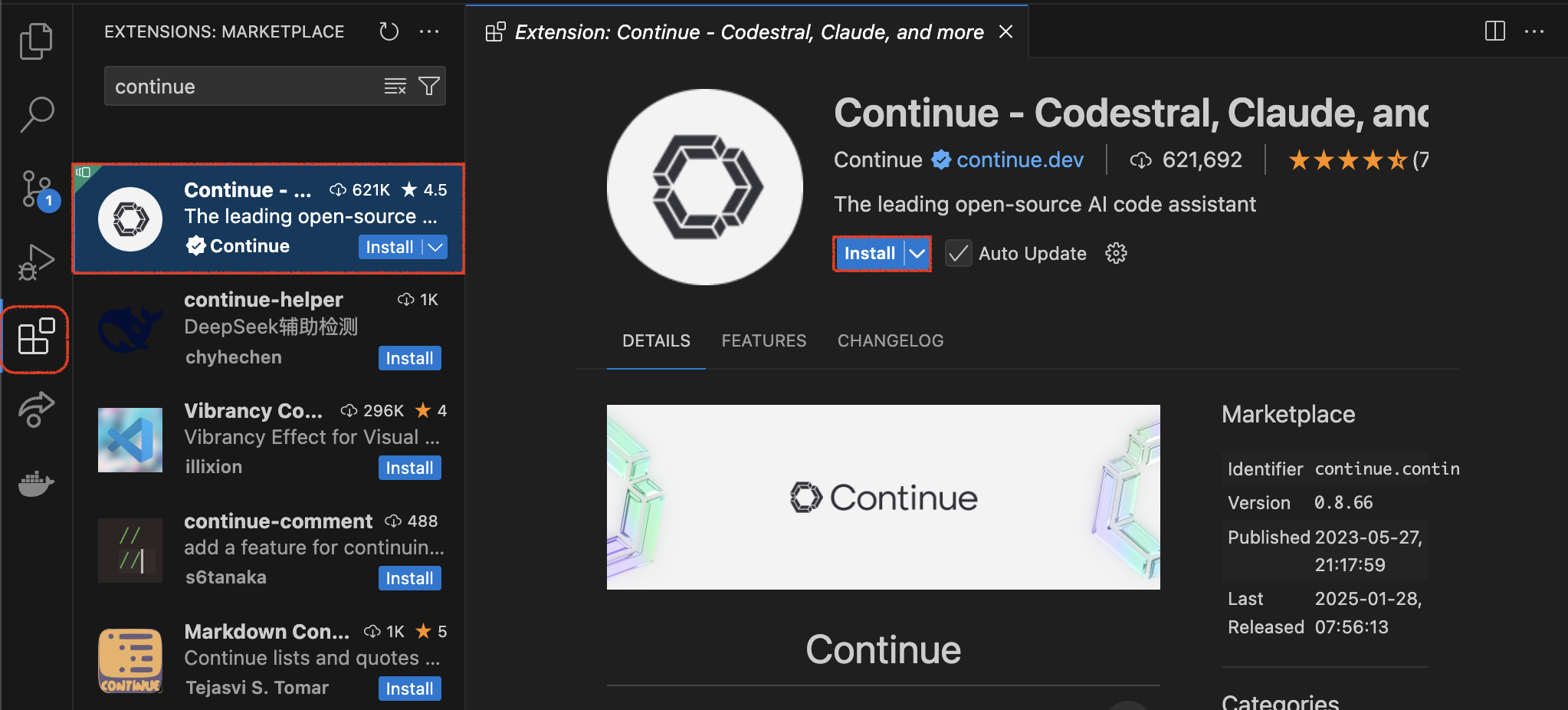

方案2.使用Continue.dev 扩展

现在,让我们将 Deepseek-r1 引入 Visual Studio Code。为此,我们将使用Continue.dev,这是一个出色的扩展,可将 VS Code 连接到 Deepseek-r1 等 LLM。此扩展将充当 VS Code 和 Ollama 之间的桥梁,允许您直接在编码环境中与 Deepseek-r1 交互。要安装 Continue.dev 扩展,请按照以下步骤操作:

-

打开 VS Code 并进入扩展市场。

-

搜索 Continue.dev 并点击安装。

-

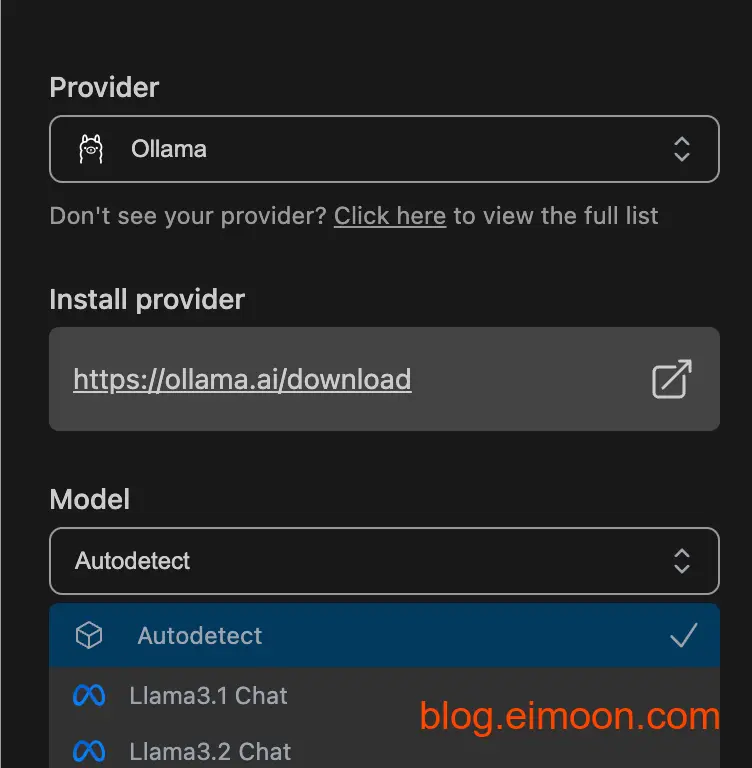

和Roo Code配置类似,点击扩展并访问“设置”。

-

在API 提供程序中,选择“Ollama”。

-

这里的模型没有DeepSeek R1,选择autodetect即可。

结论

对于那些想要获得强大的 AI 而又不想花一分钱的人来说,将 Deepseek-r1 集成到 Visual Studio Code 中极大地提高了我的工作效率。它快速、可靠且功能多样,我无需花费大量精力。无论您是经验丰富的开发人员还是刚刚起步,此设置都值得探索。

那么,你还在等什么?试试 Deepseek-r1,体验编码的未来。

关注我获取更多资讯