在当今快节奏的数字世界中,自动化不仅仅是一种奢侈,更是必需品。想想那些重复性的任务正在蚕食你的高效工作时间:数据录入、报告生成、通知管理。如果你能挥动一根魔杖,让这些任务消失,那会怎样?

这正是工作流自动化的闪光点。但真正的魔力在于自动化与人工智能的结合。想象一下,系统不仅遵循预定义的规则,还能真正学习、适应并做出决策。这正是 n8n 和模型上下文协议 (MCP) 服务器强大组合发挥作用的地方。

n8n 有何特别之处?

n8n不仅仅是一款自动化工具,更是一场变革。与许多将您锁定在其生态系统中的企业解决方案不同,n8n 秉承开源理念,让您在自动化之旅中拥有完全的自由。

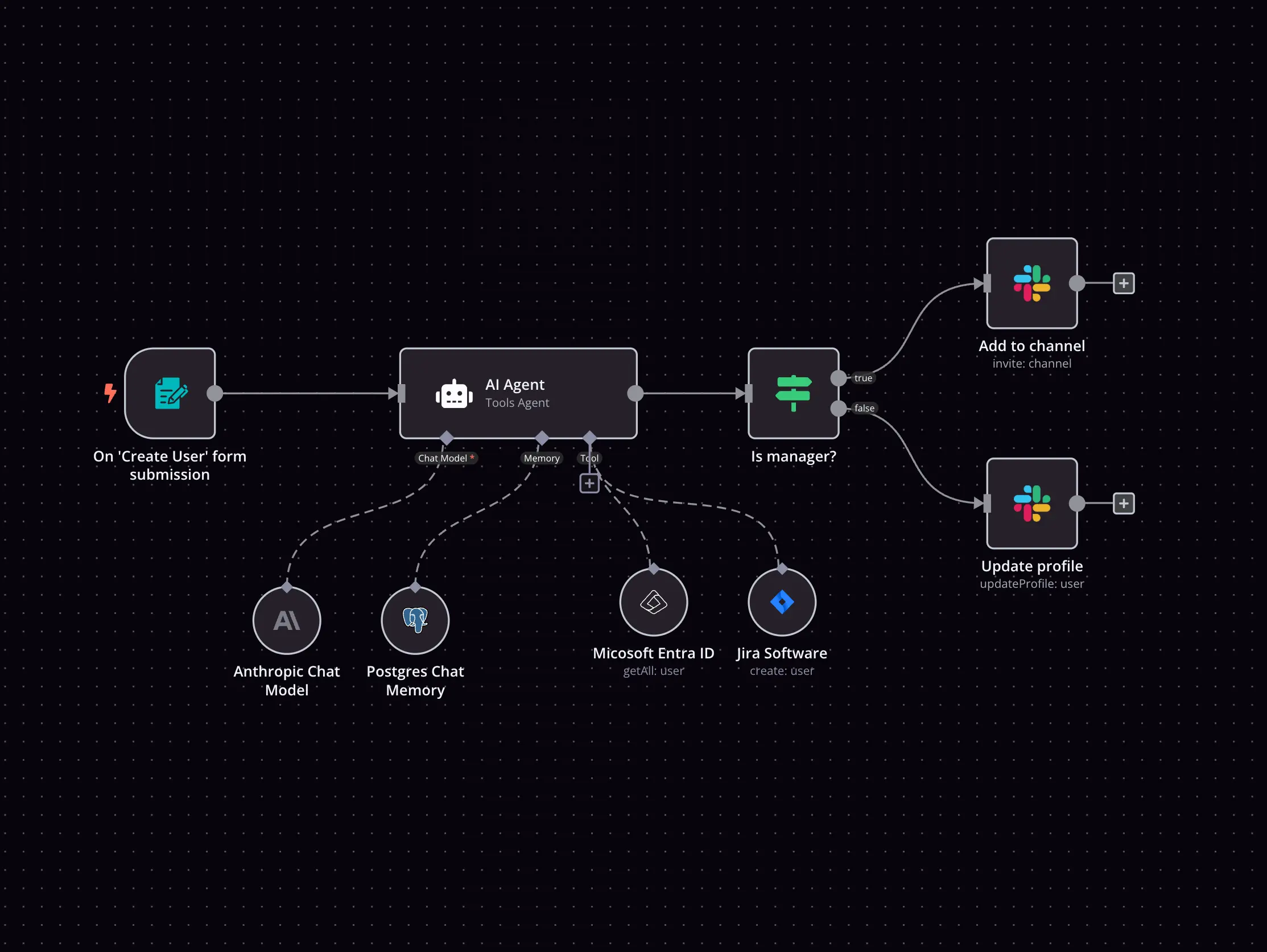

想象一幅数字画布,上面连接着代表不同服务和操作的彩色方块。每个方块(在 n8n 术语中称为“节点”)执行特定的功能——查看电子邮件、更新数据库或发布到社交媒体。当你将这些节点连接在一起时,奇迹就会发生,创建出强大的、自动运行的工作流程。

什么是 MCP 服务器?

MCP,即模型上下文协议 (MCP ),是由 Anthropic 制定的一项开放标准。它使大型语言模型 (LLM) 能够与外部工具、数据源和系统进行交互。MCP 服务器充当骨干,充当连接 AI 模型与外部世界的中介。

MCP 服务器的运作方式如下:

- 标准化访问:它们通过通用协议公开工具和数据。

- AI 交互: LLM 查询 MCP 服务器以获取信息或执行操作。

- 模块化设计:开发人员可以通过添加新工具或服务来扩展功能。 例如,MCP 服务器可能允许 AI 检查天气 API、更新数据库或触发 n8n 中的工作流。此功能将静态 AI 模型转化为动态的、现实世界的问题解决者。与 n8n 搭配使用时,MCP 服务器可以释放 AI 驱动的自动化潜力。

您可以使用 n8n 和 MCP 服务器做什么? 当 n8n 遇到 MCP 服务器时,就会发生真正变革的事情——我们创建了将基于规则的自动化的可靠性与人工智能的适应性相结合的系统。

让我们想象一下这种情况:一家中型电子商务公司正努力应对支持工单积压问题。通过将 n8n 与 MCP 连接的 AI 集成,他们创建了一个系统:

分析收到的支持单的意图和情绪 使用预建的工作流程自动解决常见问题 确定复杂案例的优先级并将其分配给适当的团队 根据客户互动不断改进响应 对于大学或机构等组织来说,他们需要处理数千篇科学论文,使用 n8n-MCP 组合来:

从各期刊出版物中提取关键发现 按主题和重要性对研究进行分类 确定研究人员之间的潜在合作 为不同的利益相关者生成定制的研究摘要 使用 MCP 服务器设置 n8n 现在,让我们配置 n8n 和 MCP 服务器,使其协同工作。请按照以下步骤建立功能集成。

步骤1:安装n8n

首先,在你的系统上安装 n8n。你有两个主要选项:

通过 npm:

npm install n8n -g

n8n start

使用 Docker:

docker run -it --rm --name n8n -p 5678:5678 n8nio/n8n

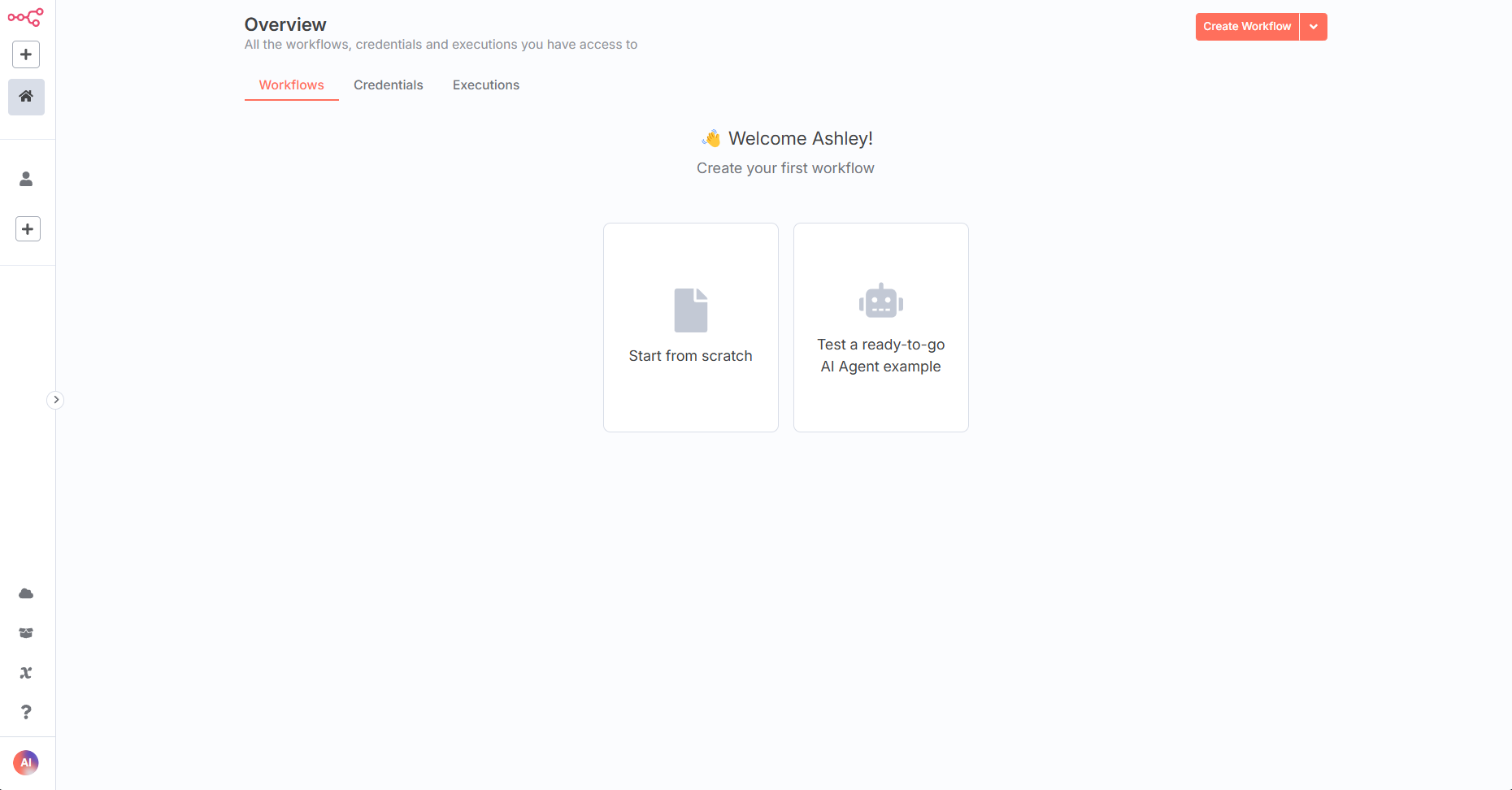

在浏览器中访问 n8n http://localhost:5678。创建一个新的工作流程即可开始。

步骤 2:设置 MCP 服务器

接下来,选择一个 MCP 服务器。访问GitHub 仓库查看可用服务器列表。本指南假设您选择基本的 MCP 服务器实现。

在本地或云实例上安装。请按照服务器的设置说明进行操作,通常包括:

- 克隆存储库。

- 安装依赖项(例如npm install)。

- 启动服务器(例如npm start)。 通过检查服务器的端点(通常位于)来验证服务器是否运行http://localhost:port/mcp。

步骤 3:在 n8n 中配置 MCP 服务器触发节点

n8n 包含一个 MCP 服务器触发器节点,可将您的工作流程转换为兼容 MCP 的服务器。设置方法如下:

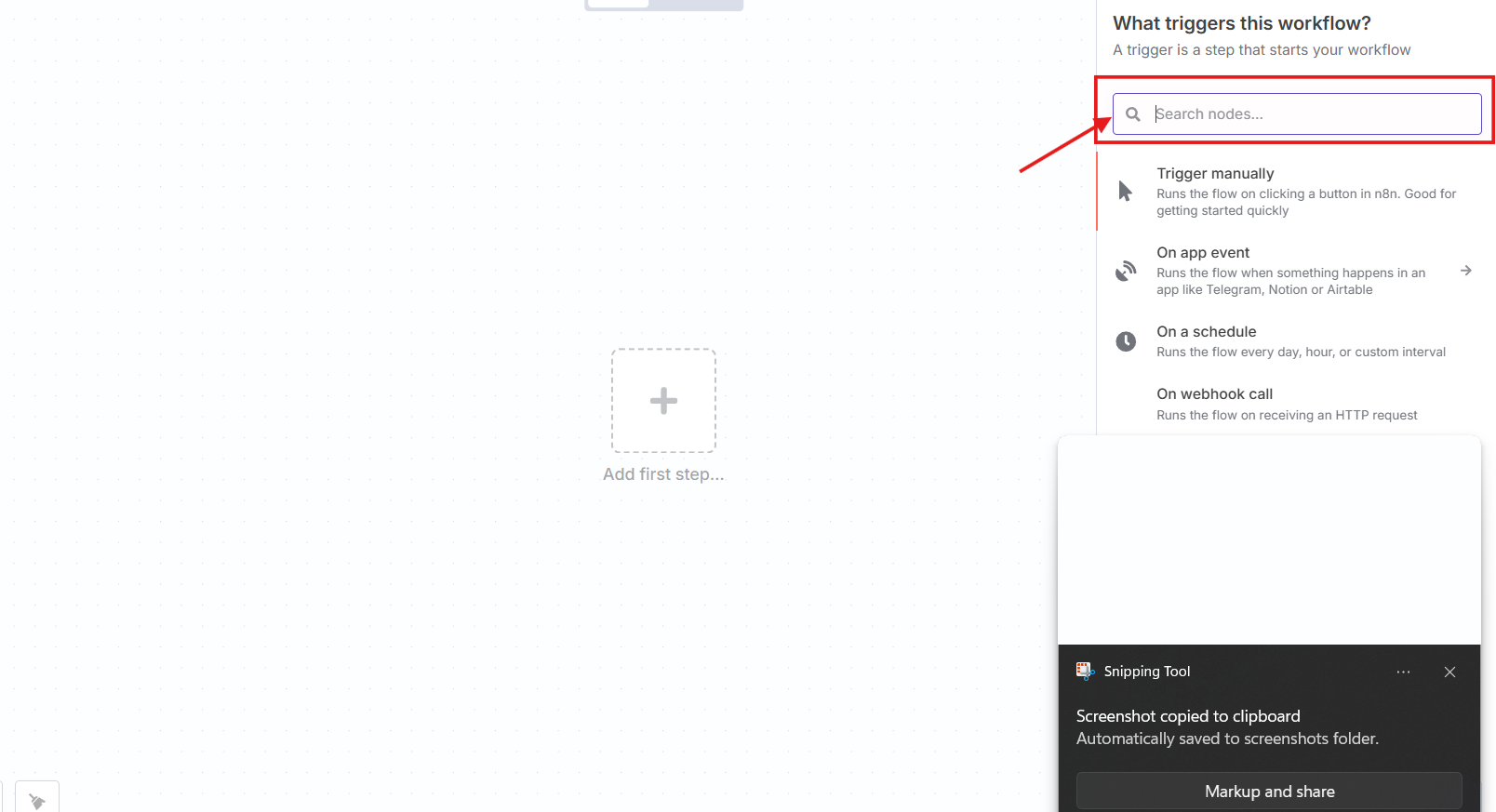

打开 n8n:启动您的实例并创建一个新的工作流程。

添加节点:在节点面板中搜索“MCP Server Trigger”并添加。

配置设置:

- MCP URL 路径: n8n 会生成一个唯一的路径(例如/mcp/abc123)。

- 身份验证:选择“无”进行测试或添加凭证(例如,API 密钥)。 将触发器链接到代表工具或操作的节点(例如,HTTP 请求节点)。保存并激活工作流。

n8n 现在公开了一个 MCP URL(例如http://localhost:5678/mcp/abc123)。

外部 MCP 客户端(例如 AI 模型)可以调用此端点。

步骤4:测试设置

使用 cURL 等工具向 MCP URL 发送测试请求:

curl -X POST http://localhost:5678/mcp/abc123 -d '{"tool": "example"}'

如果配置正确,工作流程将执行。这确认 n8n 和您的 MCP 服务器已有效通信。

在 n8n 中使用 MCP 服务器触发节点 MCP 服务器触发器节点支持此集成。它使 n8n 工作流可以作为 MCP 客户端的工具。让我们通过示例来探索它的功能。

工作原理 当 MCP 客户端向触发器的 URL 发送请求时,n8n:

接收请求。 解析有效负载(例如 JSON 数据)。 根据输入执行连接的节点。 向客户端返回响应。 这一过程使 AI 模型能够利用 n8n 的自动化功能。

示例:发送电子邮件 创建工作流程以通过 MCP 请求发送电子邮件:

添加MCP服务器触发节点:配置同上。 添加电子邮件节点:使用“发送电子邮件”节点(例如,SMTP 或 Gmail)。 连接节点:将触发器链接到电子邮件节点。 设置参数:将触发器的输入(例如to,subject)映射到电子邮件节点。 测试一下:

curl -X POST http://localhost:5678/mcp/abc123 -H "Content-Type: application/json" -d '{"to": "[email protected]", "subject": "Test", "text": "Hello from n8n!"}'

工作流程发送电子邮件,展示 MCP 驱动的自动化。

示例:获取 API 数据 构建工作流以从 API 获取数据:

添加 MCP 服务器触发节点:设置端点。 添加 HTTP 请求节点:配置它来查询 API(例如https://api.example.com/data)。 连接和映射:将触发输入(例如查询参数)传递给 HTTP 节点。 返回数据:使用“设置”节点来格式化响应。 测试:

curl -X POST http://localhost:5678/mcp/abc123 -d '{"query": "test"}'

工作流程获取并返回 API 数据,展示实时集成。

结论

将 n8n 与 MCP 服务器结合使用,可实现自动化与 AI 之间的强大协同效应。本指南向您展示了如何设置、配置和优化此集成。从安装 n8n 到利用 MCP 服务器触发器节点,您现在拥有了构建智能工作流所需的工具。

从简单的工作流程小规模测试开始,然后随着需求的增长进行扩展。无论您是要实现支持自动化、处理数据,还是增强 AI 应用,都拥有无限可能。深入探索,让 n8n 和 MCP 服务器为您的技术项目带来变革。

关注我获取更多资讯