一、llama.cpp 基础介绍

llama.cpp 是 Meta 开源的一个高效、轻量级的 LLaMA 语言模型实现。

作为 LLaMA 模型的 C++ 移植版本,llama.cpp 相比原始 Python 实现具有更快的推理速度和更低的内存占用。该项目由 Georgi Gerganov 于 2023 年 3 月创建,目前已获得数百位开发者的贡献。

其最大特点是让普通用户能够在个人电脑等消费级硬件上运行大语言模型,无需依赖高端 GPU。通过各种量化技术,llama.cpp 可以显著降低模型体积和内存占用,同时保持良好的性能表现。

值得一提的是,llama.cpp 不仅支持 Meta 的 LLaMA 模型,目前已扩展到支持 37 种不同的模型。它也启发了许多优秀项目的诞生,如 LM Studio 和 Ollama 等都是基于 llama.cpp 构建的。

主要特点

- 采用 C++ 开发,专注于模型推理优化

- 支持多平台:Windows、Linux、macOS、Android 甚至树莓派

- 通过 4-bit、GGUF 量化技术,大幅降低显存需求

- 支持在 8GB 显存的消费级显卡上运行大型模型

适用场景

- 适合开发者在本地轻量级运行大语言模型

- 适用于手机、嵌入式设备等边缘计算场景

- 特别适合需要离线使用的场景

局限性

- 仅支持模型推理,不支持模型训练

- GPU 推理速度不及 vLLM(后者采用 PagedAttention 技术)

- 接口相对底层,对新手不够友好

二、Ollama:让本地 AI 部署更简单

Ollama(全称"optimized llama")由 Jeffrey Morgan 于 2023 年 7 月创立,是一个让用户能够便捷使用本地大语言模型的工具。它以安装简单、使用方便而闻名,特别适合初学者和非技术用户。

Ollama 支持创建自定义模型并运行多种预训练模型,完全开源,促进了社区协作。Ollama默认使用的是命令行的形式,没有自带图形化界面,如果你想要类似 ChatGPT 的网页交互体验,可以参考社区提供的客户端列表,或者使用浏览器插件Page Assist

核心优势

- 对 llama.cpp 进行了友好封装,提供简洁的命令行和 API 接口

- 完善的模型管理功能:支持拉取、存储、运行各类 GGUF 格式模型

- 采用类 Docker 的容器化设计,支持通过 Modelfile 打包分发模型

- 自动识别并利用 GPU 加速(如果硬件支持)

使用场景

- 适合想要本地运行 AI 但不愿深入技术细节的用户

- 开发者快速测试和部署大语言模型

- 需要通过 API 集成到其他应用的场景

三、vLLM:面向生产环境的高性能推理框架

vLLM 是一个专为 GPU 优化的高吞吐量推理框架,特别适合云端大规模部署。

vLLM 是一个专为 GPU 优化的高吞吐量推理框架,特别适合云端大规模部署。

技术特点

- 基于 Python + CUDA 开发,深度整合 PyTorch

- 创新性的 PagedAttention 算法优化显存管理

- 支持连续批处理,可并行处理多个请求

- 原生支持主流模型架构,无需格式转换

- 提供兼容 OpenAI 的 API 服务

应用场景

- 高并发的生产环境部署

- 要求低延迟、高吞吐的 GPU 推理

- 大规模模型服务部署

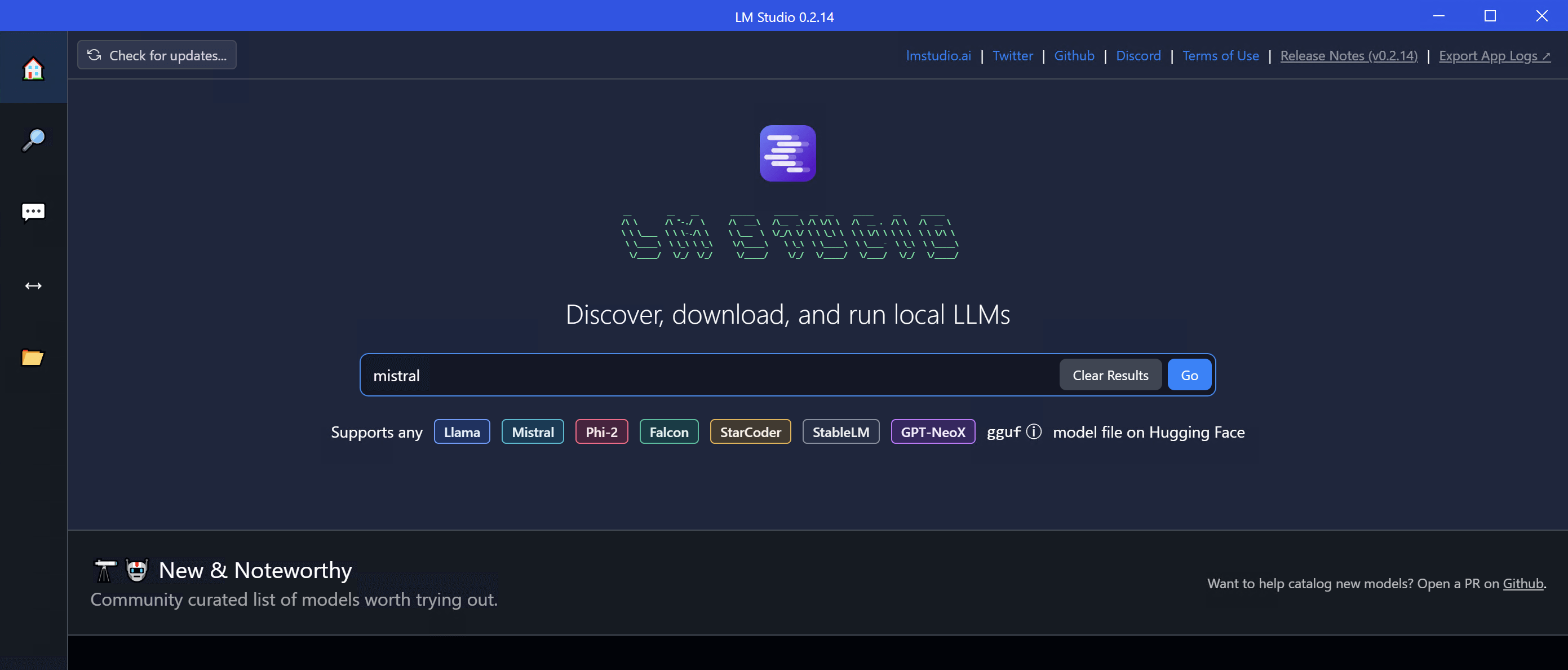

四、LM Studio:面向桌面用户的 AI 助手

LM Studio 是一款专注于本地大语言模型交互的桌面工具。它提供了直观的用户界面,支持模型发现、下载和运行,并内置了聊天界面。相比 Ollama,LM Studio 在用户界面方面更加友好,同时提供了更多来自 Hugging Face 等平台的模型选择。

产品特点

- 基于 llama.cpp 开发,提供图形界面,无需命令行操作

- 专注桌面端用户体验(区别于 Ollama 的命令行导向)

- 支持 GGUF 格式模型的下载、管理和运行

- 支持 Windows 和 macOS,内置 GPU 加速

适用人群

- 偏好图形界面的非技术用户

- 需要本地 AI 写作、问答服务的用户

- 寻找轻量级离线 AI 助手的用户

不足之处

- 不适合规模化部署

- 推理性能不及 vLLM

- 扩展性有限,缺乏类似 Ollama Modelfile 的配置能力

- 没有开源

五、总结

| 特性 | llama.cpp | Ollama | vLLM | LM Studio |

|---|---|---|---|---|

| 核心定位 | CPU/边缘推理 | 开发者本地工具 | 生产级 GPU 服务 | 非开发者桌面应用 |

| 用户界面 | 命令行 | CLI + 简单 API | API 服务器 | 图形化界面 (GUI) |

| 硬件依赖 | CPU | CPU(可选 GPU) | GPU | CPU/GPU 自动适配 |

| 模型兼容性 | GGUF/GGML 格式 | 多格式(依赖后端) | HuggingFace 原生 | HuggingFace 格式 |

| 部署复杂度 | 需手动配置 | 一键运行 | 需调优和集群部署 | 零配置,开箱即用 |

| 典型场景 | 嵌入式设备、量化推理 | 快速原型开发 | 云端高并发 API | 个人体验、非技术用户 |

| 量化支持 | ✅ | ✅(依赖后端) | ❌ | ❌ |

| 开源/闭源 | 开源 | 开源 | 开源 | 闭源(免费) |

关注我获取更多资讯